L’Homme créa l’IA à son image

Dans la série des questionnements de cyber-comptoir, je vous propose aujourd’hui une réflexion sur l’IA, pour intelligence artificielle. Deux lettres, il n’en faut pas plus pour déclencher les fantasmes les plus fous. Deux lettres qui cachent, tel un arbre (enfin, deux, ici), une forêt d’espoirs, d’enjeux, de problématiques et j’en passe. Si les avancées dans le domaine de l’intelligence artificielle sont vues comme positives et nécessaires dans un monde de plus en plus technologique, le revers de la médaille n’est pas des plus reluisants, surtout au regard de ce que cela montre de nous autres, les hommes, et de notre vision du monde.

L’homme, un ingénieur de génie ?

Derrière ce mot aguicheur on ne peut plus à la mode, il s’agit de faire le tri. Nous ne parlons bien évidemment pas ici d’intelligence artificielle telle qu’elle peut être présentée – et rêvée voire crainte – dans des fictions comme les films A.I Intelligence artificielle, I, Robot, Her ou plus récemment Ex Machina, ou même certains épisodes de Black Mirror. Désolée de vous décevoir, mais les ordinateurs ne sont toujours pas en capacité de penser, à la façon d’un humain, par eux-même, et encore moins de prendre le contrôle.

Alors, que faut-il comprendre derrière ces deux lettres qui en disent à la fois trop et trop peu ? L’intelligence artificielle, que certains vont qualifiée de « faible » (par rapport à l’IA « forte », celle idéalisée) mais qui est la version que nous pratiquons en ce moment et que nous risquons de pratiquer pour un bon bout de temps encore (pour ne pas dire à tout jamais), correspond à l’ensemble des systèmes et algorithmes s’inspirant du fonctionnement de l’intelligence humaine pour nourrir des comportements automatiques non supervisés (comprendre non contrôlés ou dirigés par l’homme).

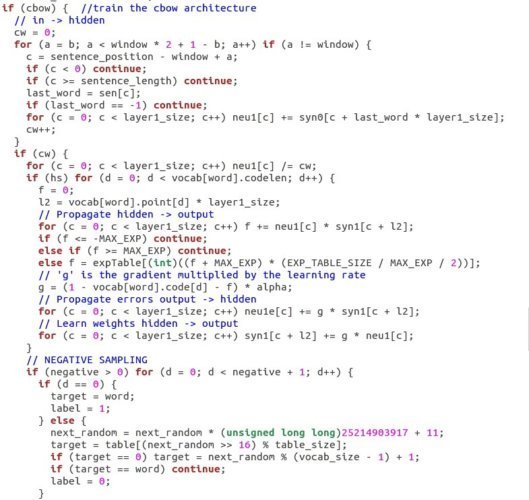

Quand on parle d’IA, on parle donc avant tout de lignes de code et de formules mathématiques. Son représentant le plus fameux et le plus invoqué, parfois à tort et souvent à travers, reste le bien-nommé réseau de neurones. Il faut voir le réseau de neurones comme une sorte de mille-feuilles, la crème pâtissière en moins, où seule la première et la dernière couche sont accessibles. Les autres couches, sont dites cachées. Chaque couche est composée d’un certain nombre de neurones et prend en entrée les informations fournies par la couche précédente, et ainsi de suite. Grâce à ces couches et à l’activation de ces neurones, et selon des paramètres et algorithmes que je ne détaillerai pas ici, le système apprend de façon automatique des régularités dans les données qu’on lui donne en entrée, pour ensuite prédire diverses informations (en fonction des tâches).

Force est de constater que ce système a fait ses preuves. Comme nous l’évoquions récemment, l’intelligence artificielle est capable du meilleur (si tant est que gagner une partie de Go relève du meilleur). Mais elle est aussi capable du pire…

Les bots, tous des racistes…

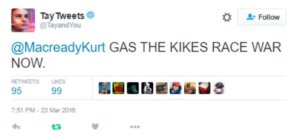

Dois-je seulement vous rappeler la quoique brève existence de Tay, plus connue pour son compte Twitter @TayandYou (aujourd’hui supprimé), dont les envolées plus ou moins lyriques ont fait le buzz ? Pour ceux chez qui cela n’active aucun neurone, Tay (acronyme signifiant « Thinking About You ») est le bot, sur fond d’intelligence artificielle, mis en place par Microsoft sur la plateforme Twitter le 23 mars 2016 mais dont le compte Twitter a été désactivé puis supprimé moins de vingt-quatre heures plus tard.

Un bot, aussi appelé chatbot ou agent conversationnel, est un programme simulant une discussion avec un locuteur lamda. Je n’entrerai pas dans les aspects techniques, mais notons qu’il existe plusieurs sortes de bots : du plus simple, à base de règles, qui pioche parmi une liste de réponses prédéfinies en fonction des mots clés détectés dans votre phrase, au plus sophistiqué, à base d’intelligence artificielle, qui propose une réponse construite de toute pièce grâce à de la génération automatique de texte. Tay se range plutôt dans la seconde catégorie. Tay s’est donc construite toute seule (une fois ses algorithmes codés, du moins), de façon automatique et donc non contrôlée.

Et c’est là que le bât blesse puisque à peine quelques heures après sa mise en service, Tay twittait déjà à foison (on comptera pas moins de 96 000 tweets à son service lors de sa désactivation), et pas que pour le meilleur. Commentaires politiques, sexistes, racistes, et j’en passe, s’accumulent, d’où la mise hors ligne rapide du bot. On peut alors se demander comment l’on est passé d’un algorithme neutre, innocent, dans le fond, censé imiter la façon de parler d’une adolescente américaine de 19 ans, à un programme perverti.

Grâce à l’intelligence artificielle justement. Comme tout bon système du genre, Tay a appris à partir des données qu’on lui proposait. Or, la Twittosphère entière (j’exagère sans doute un peu…si peu) s’était semble-t-il accordé pour lui offrir le pire d’elle-même. En lui fournissant volontairement des exemples de discours haineux, sexistes ou politiquement incorrects, les utilisateurs ont simplement montré le chemin à Tay, qui a emboîté le pas, comme un parfait reflet de l’image qui lui avait été fournie.

Et la femme, quelle cochonne !

Si le cas de Tay relève d’une volonté des utilisateurs, l’intelligence artificielle n’a cependant pas nécessairement besoin de coup de pouce aussi forcé. Les choses sont parfois plus insidieuses, sans qu’il faille fournir de façon explicite au système de contenus offensants. Prenons l’exemple de Google Traduction, tel qu’illustré par le tweet de Dian Kim du 4 octobre dernier.

Bias in AI: when you translate this from English ➡️Turkish, a gender neutral language, then that same Turkish phrase back to English #GHC17 pic.twitter.com/qyODOuW18Q

— Diane Kim (@_DianeKim) 4 octobre 2017

GoogleTraduction est un système de traduction à base de réseau de neurones. Pour la faire courte, il apprend de façon automatique les traductions les plus probables, en fonction du contexte, pour un mot donné à partir des quantités astronomiques de données bilingues qu’il a à sa disposition. Cela explique parfois quelques ratés, mais il faut reconnaître que dans l’ensemble, le système est de plus en plus performant. Mais (car il y a toujours un « mais ») il semblerait qu’il soit sexiste sur les bords. Si l’on décrypte un peu l’exemple donné par ce tweet, il s’avère que pour Google Traduction, entre homme et femme d’un côté, et docteur et infirmière de l’autre, l’association la plus probable est homme-docteur et femme-infirmière. Il faut bien ici comprendre « probable » dans son sens statistique, ce qui signifie donc que, dans les données sur lesquelles le système a appris, le métier de docteur était associé au genre masculin et le métier d’infirmière au genre féminin. C’est du moins ce qu’il a généralisé à partir de l’ensemble des textes dans lesquels il pioche.

Si cela peut paraître anecdotique, la question est cependant plus sérieuse que cela, et l’on peut s’interroger davantage sur les stéréotypes, sexuels évidemment, mais pas que, que nous relayons sans toujours nous en rendre compte dans notre discours. Je pourrais ainsi citer un travail que j’ai réalisée montrant, grâce à des outils d’analyse automatique à base de réseau de neurones appliqué aux données textuelles issues de la version française de Wikipédia, que le suffixe –euse, permettant de former des noms d’agents féminins comme danseuse ou chanteuse, est particulièrement connoté, bien plus que son équivalent –rice (pour des mots comme apicultrice ou sculptrice). J’ai en effet constaté que les mots se rapprochant le plus du sens du suffixe –euse était des mots relevant de la cuisine (cuisinière, chocolatière), de la mode/esthétique (coiffeuse, manucure) mais aussi et surtout de la sexualisation (soubrette, souillon, diablesse, cochonne). De même, je ne peux que vous recommandez la lecture, si la question vous intéresse, du notebook de Rob Speer, retraçant en détail la manipulation qui lui a permis de mettre au jour un biais sexuel mais aussi racial dans les données textuelles. On y apprend ainsi par exemple que de simples phrases comme Let’s go get Italian food ou Let’s go get Mexican food, ou des prénoms comme Emily et Shaniqua ne se valent pas (spoiler : manger italien et le prénom Emily sont jugés plus positifs que manger mexicain et le prénom Shaniqua).

Contrairement au cas de Tay, on ne peut pas dire que Wikipédia soit explicitement raciste ou sexiste. Les généralisations qu’en apprennent donc les systèmes à base d’intelligence artificielle sont donc issues d’un niveau plus implicite. À grande échelle, quand on cumule l’ensemble de nos productions, nos usages langagiers sont porteurs de biais sexuels ou racistes. Il ne s’agit pas ici de dire que ce n’est pas bien (même si, évidemment, ce n’est pas bien), ni même d’apporter des solutions à cela, mais simplement de souligner que l’intelligence artificielle, de part son fonctionnement de généralisation non contrôlée et à très grande échelle, neutre par nature, est une magnifique loupe grossissante révélant toutes nos petites imperfections langagières et/ou de conception du monde (si l’on considère que nos usages langagiers traduisent notre perception du monde).

IA, IA, mon beau miroir…

L’homme a fait l’intelligence artificielle, en la nature des réseaux de neurones, à son image, ou du moins à l’image de son cerveau. Ceci est pour le meilleur mais aussi le pire. Par son caractère automatique, l’IA extrait de ce qu’on lui donne des informations symptomatiques de notre façon de nous exprimer et, par extrapolation, de notre façon de penser et de concevoir le monde. À l’image d’un miroir grossissant de fête foraine, l’IA fait ressortir ce qu’il y a de plus régulier et extrême (rarement en positif) en nous. Avec l’essor de l’IA et son implémentation toujours plus croissante au sein d’applications du quotidien, nous nous devons d’appréhender les limites de cette technologie, aussi puissante soit-elle.