Comment choisir son écran de rêve ?

C’est là la question à laquelle cet article va tenter de répondre pour vous. En effet, il existe de nombreux paramètres pour écrans PC et ils ne sont malheureusement pas toujours clairs. Pour remédier à cela, cet article aborde une grande majorité de ces caractéristiques en essayant d’en dégager les informations essentielles.

Car oui, s’il fallait véritablement tout détailler, cet article serait très vite indigeste. Autre petite précision, cet article parle surtout des écrans pour PC fixe. Il n’y aura pas de rubrique dédiée aux télévisions ni véritablement d’aparté sur les ordinateurs portables. Cela étant, en dehors des haut-parleurs et des quelques formats existants uniquement sur laptop, les TV et ordinateurs portables intègrent toujours des écrans PC « classiques ». Cet article s’applique donc aussi indirectement aux télévisions et ordinateurs portables, même s’ils ne sont pas spécifiquement mentionnés.

Dans l’ordre je vais aborder les sujets suivants :

- Taille, résolution, courbure et format

- Connectique

- Type et sous-type de dalle

- Taux de rafraîchissement et rafraîchissement adaptatif

- Temps de réponse

- Sous-échantillonnage de la chrominance et profondeur des couleurs

- HDR, contraste et Full array local dimming

- Espace colorimétrique

- LFR, Flicker Free, Retina et autre jargon technologique

Taille, résolution, courbure et format

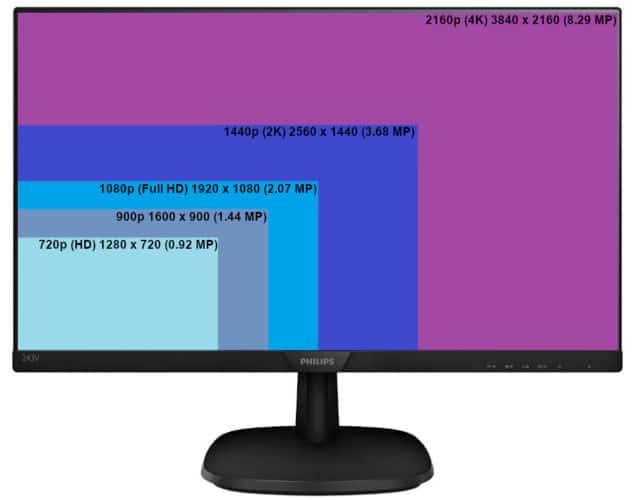

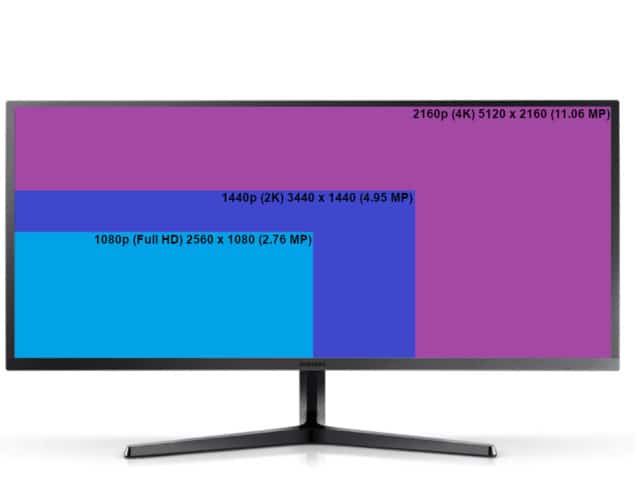

Les premières choses à regarder lors de l’achat d’un écran sont sa taille, sa résolution, son format et s’il est incurvé ou non. La taille est en pouces et informe sur la diagonale de l’écran. La résolution est en pixels avec la composante horizontale en premier puis la composante verticale. Quant au format, il se présente sous la forme d’un ratio entre la largeur et la hauteur de l’écran.

Je ne vous ferai pas l’affront de vous expliquer ce que 22 pouces ou 1920*1080 veulent dire, ce sont des notions qui parlent d’elles-mêmes. En revanche, pour les plus débutant d’entre vous, il est intéressant de parler un peu des formats et de la courbure des écrans.

Le format le plus courant est le 16:9. Il est utilisé par l’écrasante majorité des TV et écrans PC et c’est aussi le format de prédilection des vidéos YouTube. Ensuite vient un format qui gagne en popularité, le 21:9 aussi appelé Ultrawide qui élargie l’écran de 31%. Puis restent les formats moins courants comme le 4:3 et le 5:4, d’anciens formats bien plus carrés. Ou encore le 32:9 (parfois appelé SuperWide ou Super Ultra Wide) qui n’est rien d’autre que l’équivalence de deux écrans 16:9 collés ensemble.

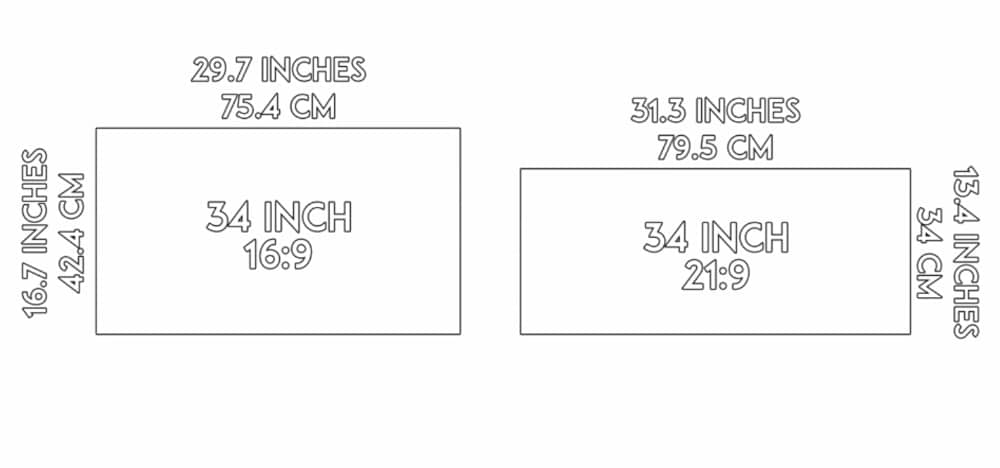

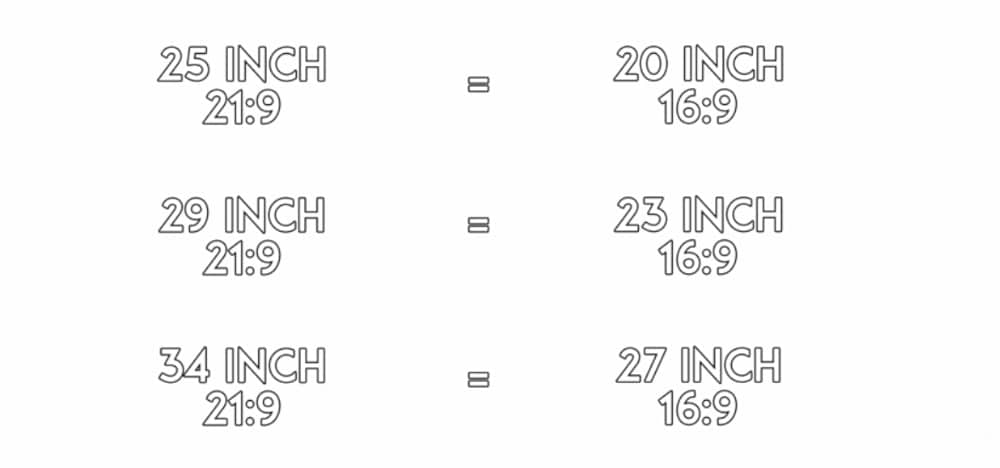

Mais c’est là qu’intervient la première petite difficulté. En effet, la taille étant donnée en diagonale, un écran 27 pouces au format 16:9 n’aura pas la même « taille » qu’un écran 27 pouces 21:9. Si taille est entre guillemets c’est parce qu’en réalité ces deux écrans ont bien la même taille, 27 pouces. Mais visuellement parlant un 27 pouces 21:9 parait bien plus petit qu’un 27 pouces 16:9, du fait qu’il est étiré et donc aplati.

Pour prendre un exemple concret, un écran 16:9 de 34 pouces fait 75.4 cm de large et 42.4 cm de haut, alors qu’un écran 21:9 en 34 pouces fait certes 79.5 cm de large, mais uniquement 34 cm de haut ! Donc si vous voulez un écran 21:9 qui soit « comparable » à un équivalent 16:9 il faut suivre les recommandations de l’image ci-dessous.

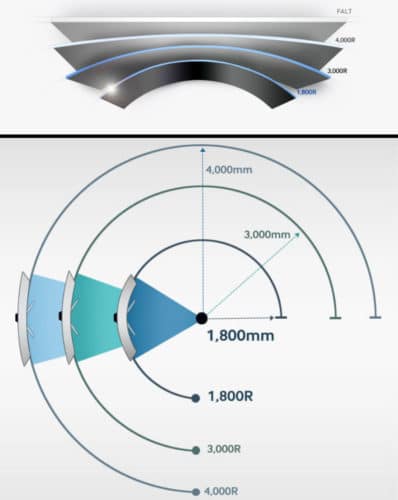

Dernier paramètre la courbure : certains écrans PC en ont une et celle-ci est indiquée avec un nombre suivi de la lettre « R ». Pour savoir ce que le chiffre signifie, l’image ci-dessous constitue l’explication la plus simple. Le chiffre indique donc le rayon d’un cercle imaginaire dont l’écran épouse la courbe. De ce fait, plus la valeur « R » est petite, plus l’écran est incurvé.

Cette courbe a pour effet de rapprocher les bords de l’écran de vous. Ainsi, chaque point de l’écran est à la même distance de vos yeux. Contrairement à un écran plat où les extrémités sont bien plus loin de vous que ne l’est le centre de l’écran.

Ceci étant, ne jetez pas tout de suite votre écran plat. Certains trouvent cette courbe inesthétique, inutile, voir même gênante. Donc faites-vous votre propre avis, la courbure n’est qu’une option et son appréciation est à chacun différente.

Connectique

On pourrait ici s’attarder sur toutes les connectiques existantes. Mais afin de rester cohérent, on va imaginer que vous ne rêvez pas d’écrans datant de 2010, ayant pour seul connectique un port VGA et un DVI-D. Commençons donc par le plus versatile et les plus courants, HDMI et DisplayPort.

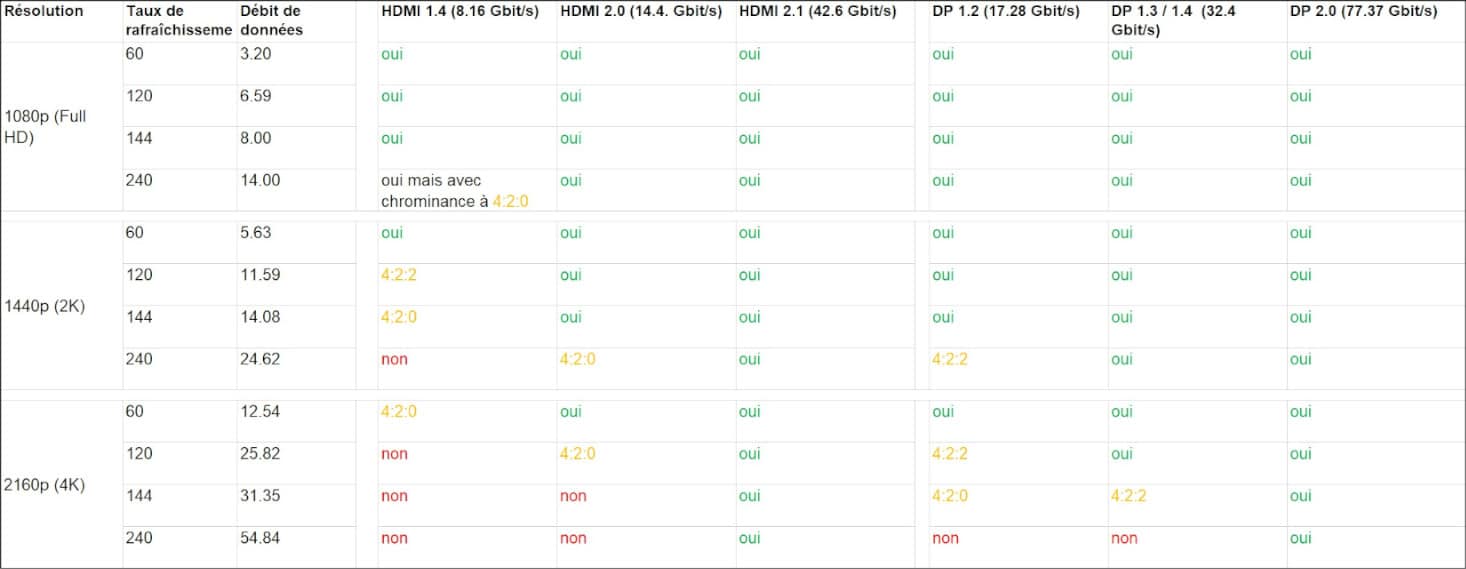

Le HDMI, tout comme le DisplayPort, existent en plusieurs versions. Six versions sont intéressantes : HDMI 1.4, HDMI 2.0, DP 1.2, DP 1.3/1.4 qui sont les versions actuellement disponibles sur le marché. Mais également le HDMI 2.1 et le DP 2.0 dont les spécifications sont finalisées et dont l’entrée sur le marché va se faire gentiment.

Chacune de ces versions supporte un certain débit de donné. Plus ce débit est élevé, plus il permet d’augmenter la résolution maximale supportée mais aussi le taux de rafraîchissement ainsi que le sous-échantillonnage de la chrominance (deux notions vues plus tard dans l’article).

Le dernier connecteur moderne intéressant à mentionner est l’USB-C. Celui-ci n’est présent que sur quelques écrans PC mais se démocratise de plus en plus de par sa versatilité. En effet l’USB-C est un connecteur bon à tout faire, il peut transporter :

- Un signal USB allant jusqu’à 20 Gbit/s pour l’USB 3.2 gen 2×2 et jusqu’à 40 Gbit/s pour le futur USB4.

- Un signal PCIe 3.0 4x pour les ports certifiés Thunderbolt 3.

- Jusqu’à 100 watts de puissance pour les ports certifiés PD pour Power Delivery (10 volts et 5 ampères).

- Un signal HDMI 1.4.

- Un signal DisplayPort 1.4.

Il est donc tout à fait possible de brancher son ordinateur portable en USB-C à un écran et d’ainsi non seulement profiter du lien USB, mais aussi des 100 watts pour charger le laptop ainsi que du signal vidéo HDMI ou DP pour utiliser l’écran, le tout en un seul câble !

Type et sous-type de dalle

Pour commencer, qu’est-ce que « type » veut dire dans ce contexte ? Par type de dalle on entend la technologie utilisée pour fabriquer la partie de l’écran qui affiche une image. En effet, il existe plusieurs méthodes pour créer des pixels et il existe plusieurs méthodes pour éteindre et allumer ces derniers.

Plutôt que de rentrer dans les détails techniques de chaque dalle, passons en revue les forces et faiblesses de ce technologies :

|

C’est la technologie LCD la plus ancienne du lot. Les angles de vue sont mauvais, à savoir que l’image s’assombrit et les couleurs sont altérées si l’on n’est pas bien en face de l’écran. La reproduction des couleurs est mauvaise et le contraste est plutôt faible. Mais tout n’est pas noir pour cette technologie qui reste encore aujourd’hui la plus rapide. Pour cette raison les écrans 240 Hz et autre écrans destinés aux jeux vidéo ultra compétitifs utilisent souvent une dalle TN, ceci afin de profiter d’un temps de réponse le plus bas possible. | |

|

La technologie VA possède de meilleurs couleurs et angle de vision que du TN, mais sans être aussi bonnes que ce qu’un IPS peut faire. Le temps de réponse est très correct même si loin de ce dont le TN est capable. En revanche, le contraste est excellent, il n’y a guère que l’OLED pour faire mieux que le VA dans ce domaine.

Parfois vous rencontrerez les termes PVA, S-PVA, MVA ou encore AMVA mais tous sont similaires et peuvent être mis dans la famille VA. |

|

|

On a ici à faire au Graal des graphistes. En effet, les angles de vue et la reproduction des couleurs sont excellents. Quant au contraste, il peut aussi être très bon, mais attendez-vous à payer cher si vous souhaitez vous approcher de ce qu’un VA peut faire. Car la technologie IPS peut produire un grand contraste mais n’a pas ce « don naturel » qu’a le VA.

Parfois vous verrez des écrans parler de dalle PLS et AHVA, sachez que ces deux technologies sont similaires à l’IPS |

|

|

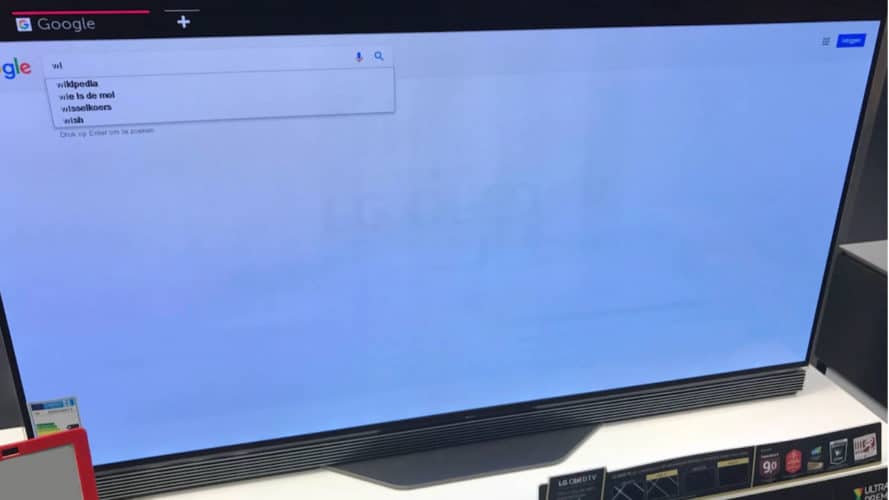

Une technologie très prometteuse. Chaque pixel OLED est sa propre source de lumière, on peut donc les éteindre individuellement créant un noir parfait et ainsi un contraste théoriquement infini. Côté reproduction des couleurs et angle de vision le résultat est bluffant tellement il est magnifique. Quant à la latence elle est extrêmement faible, faisant de l’OLED un écran parfait, mais uniquement sur le papier. En effet si quasiment aucun écran PC n’est équipé OLED ça n’est pas sans raison. Premièrement l’OLED reste une technologie chère comparée à la famille des LCD (dont TN, VA et IPS font partis). Deuxièmement l’OLED est sujet au problème du burn in (image ci-dessous). Ce problème survient quand un groupe de pixels reste inchangé trop longtemps (pensez à votre barre de tâches et à vos icônes de bureau). Les molécules organiques formant les pixels en question se détériorent et peuvent alors rester comme coincés, incapable de désafficher complètement l’image. Une sorte de fantôme de l’image précédente reste affichée par-dessus le nouveau contenu. Même si le problème est activement combattu par les fabricants d’écrans OLED, il n’est pas complètement éliminable ce qui explique partiellement l’absence quasi totale d’OLED dans le milieu PC. |

|

|

Avant de parler des mini LED il faut préciser une chose concernant les écrans LCD en général. À savoir qu’un écran LCD possède un rétro éclairage qui est tout le temps allumé. De ce fait, pour afficher du noir, il faut bloquer cette lumière. Mais ce blocage n’est jamais parfait, raison pour laquelle un écran LCD noir apparaît toujours légèrement grisé, l’exception étant l’OLED. En effet comme dit précédemment, les pixels OLED sont leur propre source de lumière. Donc pas besoin de rétro-éclairage. Mais l’OLED souffrant de burn in la développement de nouvelle technologie s’est poursuivit, donnant naissance au mini LED.

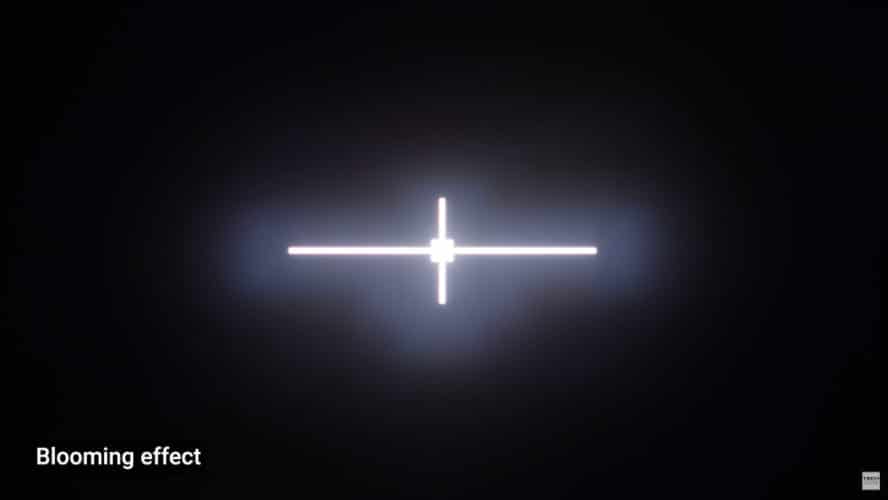

Un écran mini LED utilise un rétro-éclairage positionné derrière l’écran, ce que certains écran LCD « classique » font déjà. Cependant un écran LCD possède des LED allant de 1 à 0.1 millimètre. De ce fait, même en les éteignant par petit groupe, un halo lumineux (image ci-dessous) persiste à la limite entre une zone éteinte et une zone allumée. Mais c’est là qu’interviennent les écrans mini LED. Avec leurs LED de 0.01 millimètre le halo entre deux zones est presque inexistant, produisant ainsi un noir bien plus convainquant. |

|

|

La technologie la plus chère de ce tableau. Tellement chère qu’il est impossible de mettre la main dessus en tant que particulier, elle est donc uniquement présente ici pour votre culture générale. Ce prix vient de la taille des LED utilisées pour éclairer les pixels. Là où un écran classique utilise des LED d’environ 0.1 à 1 millimètre un écran micro LED utilise des LED de 0.01 millimètre ! C’est cette petite taille qui permet de créer des dalles contenant des millions de LED. Cette ultra haute densité de LED permet d’obtenir un rendu du même calibre que l’OLED mais sans rencontrer le problème du burn in. Cela va même plus loin, car non seulement les pixels micro LED produisent leur propre lumière (comme l’OLED) mais ils sont en plus capable d’une plus grande intensité lumineuse que l’OLED.

Attention ! On pourrait croire que le Micro LED est une itération du Mini LED, il n’est est rien. Le Mini LED est une technologie de rétroéclairage, la partie « pixels » de l’écran doit toujours êtes ajoutée par-dessus. En revanche le Micro LED est un type de dalle, les LED de 0.01 millimètres sont ici responsable de tout : luminosité et couleur. C’est donc en ça que le Micro LED est proche de l’OLED, il n’a pas de rétroéclairage additionnel, celui-ci fait parti du pixel. |

Maintenant que choisir pour votre utilisation ? Pour faire simple il y a trois grandes catégories de consommateurs :

- Pour les joueurs ultra compétitifs dont le niveau de jeu justifie un écran 240 Hz, prendre du TN semble faire du sens. Vous profiterez d’un écran au temps de réponse extrêmement bas et au taux de rafraîchissement le plus élevé… Ou du moins c’était le cas. Car il existe maintenant des écrans VA et IPS 240 Hz qui rivalisent avec les 240 Hz TN. Du fait que les technologies IPS et VA offrent une qualité d’image nettement supérieure au TN, il n’existe donc plus de réelle raison d’acheter de TN, hormis le prix relativement bas de cette technologie.

- Pour les créateurs de contenu, que ce soit pour de la photo de la vidéo ou autre, optez pour l’IPS ou éventuellement un des rares écrans PC OLED ou mini LED. Vous obtiendrez un bon contraste et une reproduction des couleurs irréprochables.

- Pour les utilisateurs et/ou joueurs « classiques » le choix est plutôt libre. Vous pouvez opter pour l’IPS, celui-ci étant disponible avec une latence relativement faible et un taux de rafraîchissement allant jusqu’à 165 Hz en 1440p et 240 Hz en 1080p. Ou alors vous pouvez faire le choix du VA, moins cher que l’IPS et profitant d’un meilleur contraste au détriment de couleurs un peu moins bonnes.

Taux de rafraîchissement et rafraîchissement adaptatif

Posons la base : le taux de rafraîchissement d’un écran c’est le nombre de fois que l’image affichée est mise à jour par secondes. Pour tous les écrans PC modernes, le minimum est de 60 rafraîchissements par secondes soit 60 Hertz (Hz) ou une nouvelle image toutes les 0.016 secondes. Mais il existe d’autres taux de rafraîchissement (75, 120, 144, 165, 240…). Alors, par exemple, qu’apporte un changement de 60 à 120 Hz ?

Cela apporte de la fluidité. Passer de 60 à 120 Hz signifie mettre à jour l’image affichée toutes les 0.0083 secondes au lieu de toutes les 0.016 secondes. Cette fluidifié constitue un confort pour l’utilisateur et aussi un avantage compétitif. En effet, si l’image est mise à jour plus régulièrement, vous avez la possibilité de réagir plus vite à un événement donné. Si vous souhaitez une preuve qu’un taux de rafraîchissement plus élevé constitue un avantage compétitif, vous pouvez aller jeter un œil ici et ici ainsi que sur le blog de Nvidia.

Donc un taux de rafraîchissement plus rapide, c’est bon à prendre, mais qu’en est-il du tearing ? Bon, ne brûlons pas les étapes, avant de chercher à l’éliminer, c’est quoi le tearing ? C’est un artefact, un bug visuel où l’image est coupée horizontalement. Ceci est dû au fait que l’écran rafraîchit l’image affichée à intervalle régulier, alors que la carte graphique envoie une image dès qu’elle est prête et non pas à intervalle régulier. C’est cette désynchronisation qui cause le tearing.

Pour combattre ce problème est née la technologie d’Adaptive Sync dont le principe est assez simple, à savoir faire varier le taux de rafraîchissement de l’écran. Mais l’Adaptive Sync n’est qu’une base sur laquelle AMD et Nvidia ont itéré pour créer leur propre standard. Ainsi côté Nvidia on parle de G-SYNC alors qu’AMD parle de FreeSync et même si la base est commune le résultat final diffère. Passons donc en revue ces standards :

|

Il s’agit du standard de base qui permet à un écran de caler son taux de rafraîchissement sur le frame rate de votre carte graphique. | |

|

C’est là le nom utilisé par AMD pour parler de rafraîchissement adaptatif. Il diffère du standard de base de par des exigences qualités supplémentaires de la part d’AMD. Ce qu’AMD entend par là c’est une liste de test et un tri pour sélectionner les écrans avec la latence la plus faible possible. | |

|

C’est là une amélioration de la norme FreeSync. Un écran avec cette norme doit :

|

|

|

Anciennement appelé FreeSync 2 HDR, il s’agit de la norme la plus exigeante qu’AMD offre actuellement. On garde ce que la norme Premium demandait et on ajoute :

|

|

|

L’implémentation de Nvidia. Elle a la particularité d’être bien plus sélective et de demander des modifications hardware de l’écran. En effet, pour être à la hauteur des exigences d’Nvidia, la firme modifie les écrans en y ajoutant un circuit imprimé disposant de mémoire RAM et d’un processeur (un FPGA pour être exact). Ce circuit rend les écran G-SYNC bien plus cher que les écrans FreeSync mais permet à Nvidia de certifier un produit :

|

|

| On a faire à un standard moins exigeant que le précédent. Celui-ci ne requière plus de FPGA, ni de plage de rafraîchissement commençant à 1 Hz. De ce fait les écrans G-SYNC compatibles se vendent à un prix similaire aux écrans FreeSync. | ||

|

Cette fois-ci on part à l’opposé avec une norme ultra exigeante. C’est en réalité une amélioration de la norme G-SYNC. On retrouve donc un FPGA mais encore plus cher et complexe car celui-ci gère la HDR en plus du rafraîchissement adaptatif. Cerise sur le gâteau, Nvidia utilise le standard VESA HDR1000, gage de qualité dont nous parlerons au point dédié à la HDR. |

La dernière chose à mentionner est l’inter-compatibilité. En effet, Nvidia et AMD fabriquant tous les deux des cartes graphiques et ayant chacun développé leur version de l’Adaptive Sync, il est nécessaire de faire attention. Ainsi un écran FreeSync peut être utilisé avec une carte graphique Nvidia mais sous certaines conditions.

À savoir qu’il vous faudra une carte GTX série 10 (ex : GTX 1070), 16 (ex : GTX 1660Ti) ou une RTX série 20 (Ex : RTX 2070) et le pilote 417.71 au minimum. Si votre carte graphique ou votre pilote est trop ancien, vous ne pourrez pas activer la FreeSync. Finalement sachez que si l’écran FreeSync que vous achetez n’est pas dans la liste des écrans PC G-SYNC Compatible vous n’avez aucune garantie sur la qualité de l’expérience FreeSync. Par là il faut comprendre que la plage de rafraichissement peut être petite, le temps de réponse non-idéale, des artefacts graphiques peuvent se produire etc.

En conclusion, si vous souhaitez acheter un écran FreeSync avec une carte graphique Nvidia il est donc préférable d’en prendre un figurant sur la liste G-SYNC Compatible ou de consulter les avis d’utilisateurs avant de passer à la caisse. Nvidia mettant du temps à certifier un écran, il est totalement possible que l’écran ne soit pas sur la liste Nvidia mais offre pourtant une très bonne expérience de jeu.

Pour ce qui est des possesseur d’un GPU AMD la question de l’inter-compatibilité est plus simple. Les écrans G-SYNC Compatible étant des écrans FreeSync validé par Nvidia ceux-ci sont évidemment compatible avec une carte graphique AMD. Pour ce qui est des écrans G-SYNC et G-SYNC Ultimate ils ont étés rendus compatible avec les GPU AMD en novembre 2019 MAIS : ce changement n’est pas rétro-actif ! Ceci veut dire que seul les écrans sortis après cette mise-à-jour sont utilisables avec une carte graphique AMD.

Temps de réponse

Huit millisecondes ici ! Cinq chez cette autre marque, qui dit mieux ? Une milliseconde pour la concurrence ! Adjugé vendu ! C’est une caricature mais malheureusement trop proche de la réalité. Le temps de réponse est une caractéristique souvent sur-vendue alors qu’elle n’est même pas présentée correctement.

En effet aucun écran n’a une milliseconde de temps de réponse. Car le temps de réponse total ou réel prend en compte deux composantes :

- Le temps nécessaire à l’écran pour recevoir l’information envoyée par la carte graphique et transmettre tout ça aux pixels (appelé parfois input lag).

- Le temps nécessaire au pixel pour changer d’état une fois le signal électrique reçu.

C’est souvent ce deuxième temps qui est renseigné sur les boîtes et pages de fabricants d’écrans. On donne donc une valeur approximative (personne n’écrit 4.1 ou 6.3, c’est habituellement 5 ou 1) et on omet totalement de parler de l’input lag.

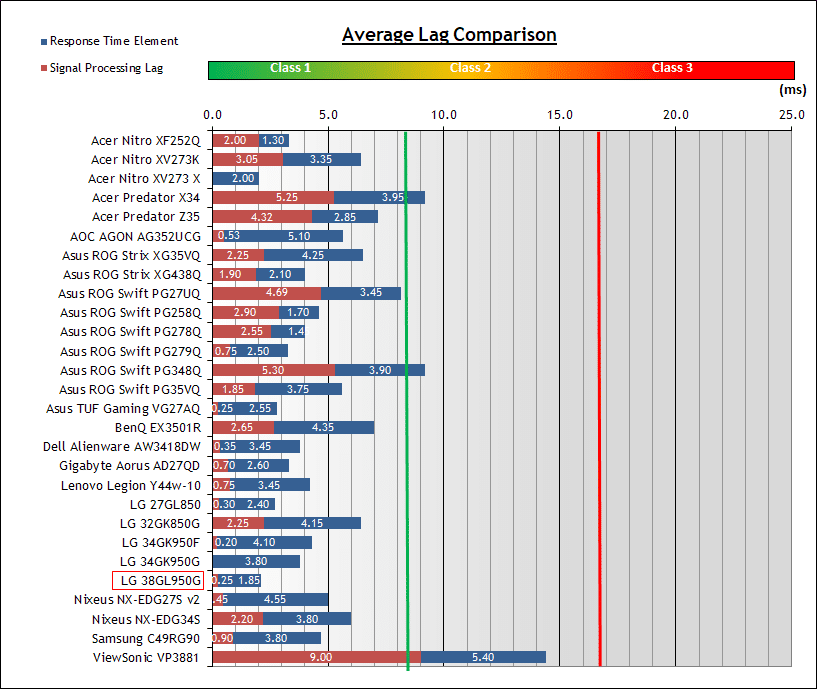

Mais alors comment connaître le temps de latence réel d’un écran ? Il faut le tester, ou plutôt consulter les tests de ceux qui ont le matériel nécessaire. Les sites et chaîne YouTube effectuant ce type de tests sont les suivant :

Sous-échantillonnage de la chrominance et profondeur des couleurs

En voilà un titre barbare. Pourtant il s’agit de concepts relativement simples. Prenons d’abord le sous-échantillonnage : pour commencer il faut savoir que pour définir l’état d’un pixel seules trois informations sont nécessaires :

- Y : La luminance ou intensité lumineuse

- CB : la chrominance différence bleu ou la quantité de bleu dans le mélange RVB (rouge vert bleu)

- CR : la chrominance différence rouge ou la quantité de rouge dans le mélange RVB.

Il n’est pas nécessaire de préciser la quantité de vert car elle est obtenable par calcul : Y = [ratio] R + [ratio] V + [ratio] B ainsi CB = B – Y, CR = R – Y et CV constitue la part restante. Sachez qu’il existe d’autres manières de calculer ces proportions mais nous en resterons à celle-ci afin de simplifier les choses et d’éviter de devoir rentrer dans les détails du calcul matriciel.

Le deuxième point important est plus humain que technologique. À savoir que l’œil est plus sensible aux changements d’intensité lumineuse qu’aux changements de couleurs. C’est pourquoi quand il s’agit de compresser un flux vidéo, c’est la composante colorimétrique qui est sacrifiée.

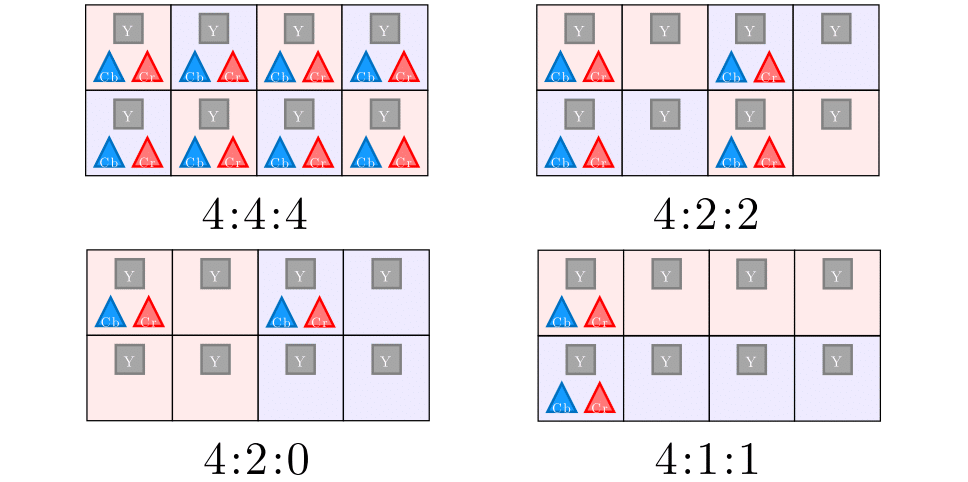

Ceci nous amène enfin sur le sous-échantillonnage. On l’a vu un pixel nécessite trois composantes pour être défini. Mais renseigner l’état de chaque pixel demandant beaucoup de bande passante, il a été imaginé un système où certains pixels ne recevraient plus ses informations de chrominance. Ceci étant, on a défini le sous-échantillonnage sur une bande de deux pixels sur quatre.

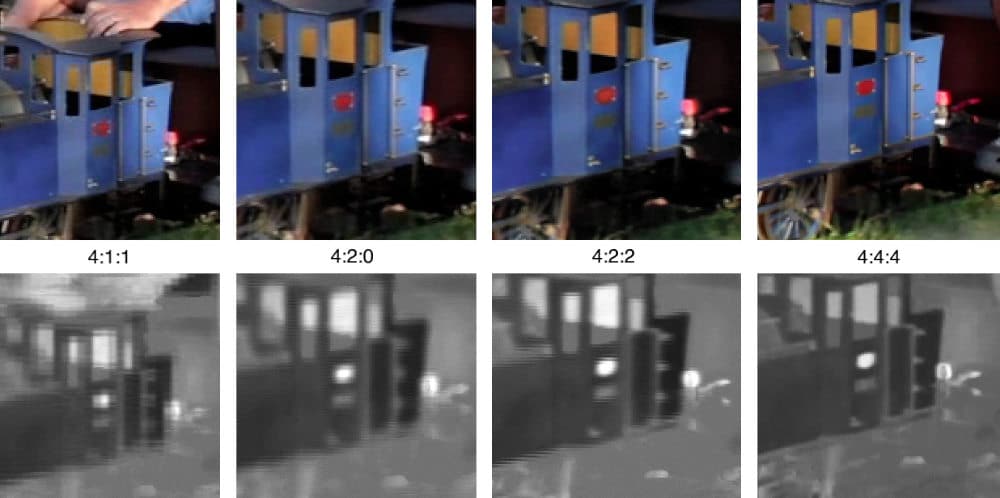

- La chrominance de base c’est la version sans perte qui se note 4:4:4 car pour quatre pixels on a quatre échantillons Y, quatre CB et quatre CR.

- La chrominance souvent utilisée par le grand public est une version légèrement compressée notée 4:2:2. Ici CB et CR ne sont renseignés qu’un fois sur deux ce qui réduit le débit d’un tiers sans un trop grande perte en qualité.

- Les chrominance les plus compressées se notent 4:2:0 et 4:1:1. Ici la différence de qualité est clairement notable du fait que seul deux pixels sur huit reçoivent leurs valeurs CB et CR.

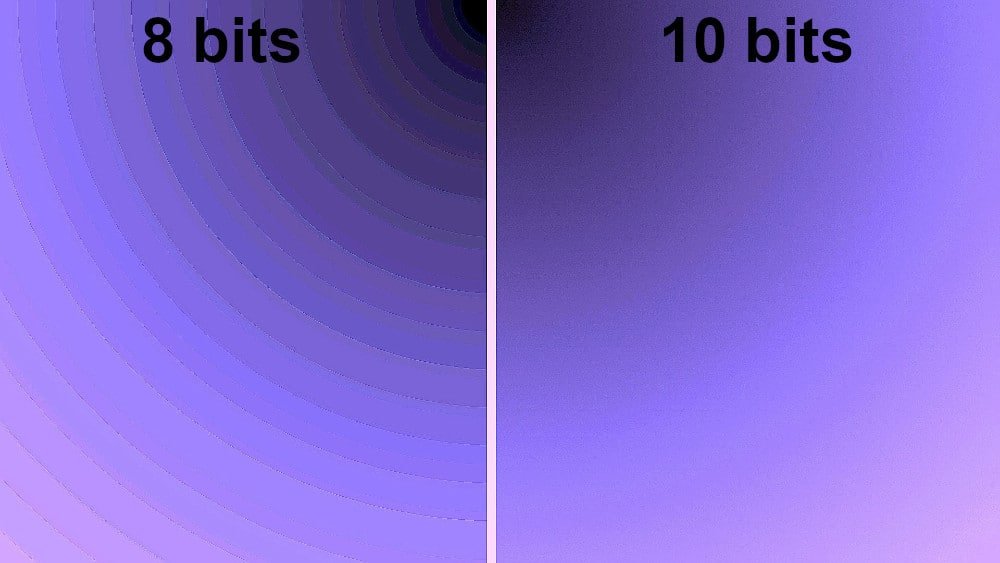

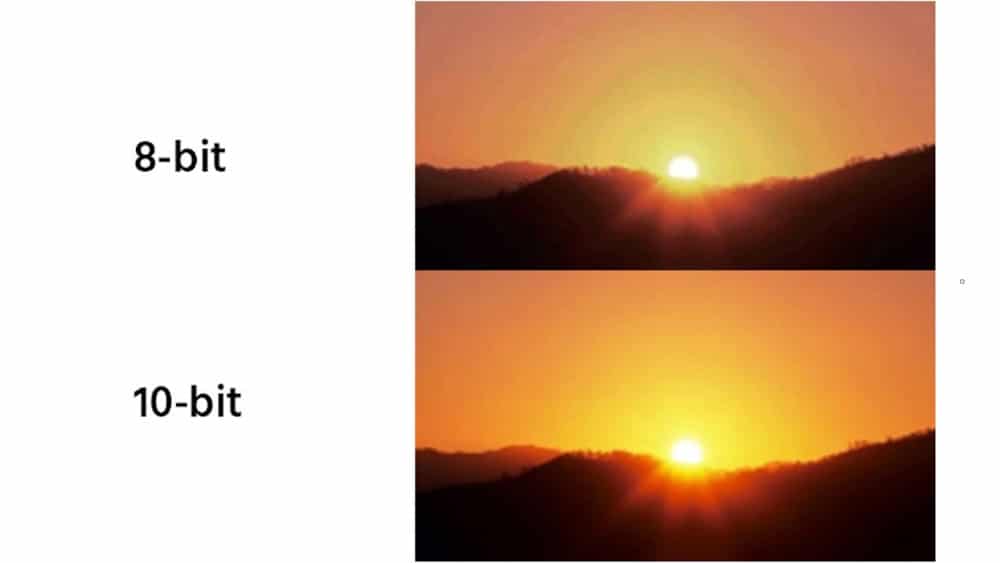

Pour finir parlons profondeur des couleurs. Il s’agit là encore d’une histoire de quantité d’informations dans le domaine de la couleur. Cette profondeur des couleurs se note en bits : 6 bits, 8 bits 10 bits etc.… et renseigne sur la richesse des couleurs.

- Le 6 bits stocke 260 000 couleurs ou 64 nuances de rouges, 64 de verts et 64 de bleu.

- Le 8 bits, format le plus courant, stocke 16 millions de couleurs, 256 nuances de rouge, 256 de vert et 256 de bleu.

- Le 10 bits stocke 1 milliards de couleurs soit 1024 x 1024 x 1024.

Pour ce qui est de l’intérêt se de pouvoir stocker autant de valeurs différentes, il permet de conserver la qualité des images très contrastées ou aux images riches en couleurs. Par exemple un coucher de soleil, des reflets sur l’eau ou une image HDR. Dans tous ces cas avoir un plus grand nombre bit permet de lisser les transitions entre couleurs en adoucissant les dégradés.

On a donc deux paramètres qui gèrent les couleurs : la profondeur des couleurs et la chrominance. Tous deux participent à une meilleure qualité d’image au détriment d’un flux de données plus lourd. Pour cette raison il est important de vous référer au tableau affiché plus haut, dans le point traitant des connectiques, afin d’acheter les bons câbles et le bon écran pour profiter de la meilleure expérience possible. Ces deux paramètres étant réglables manuellement ce sera aussi à vous d’équilibrer, selon vos préférences, taux de rafraîchissement, profondeur des couleurs de sous-échantillonnage de la chrominance.

HDR, contraste et Full array local dimming

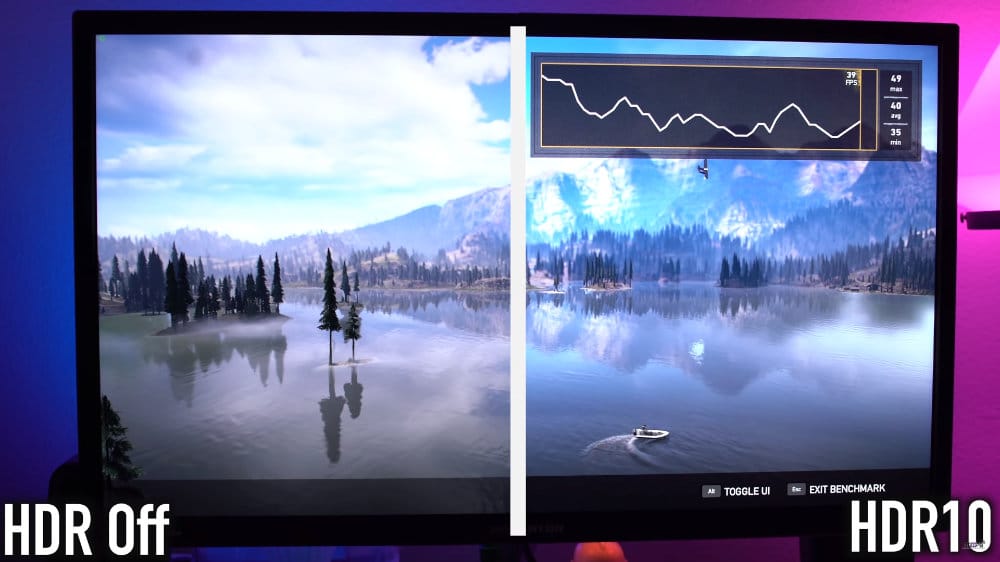

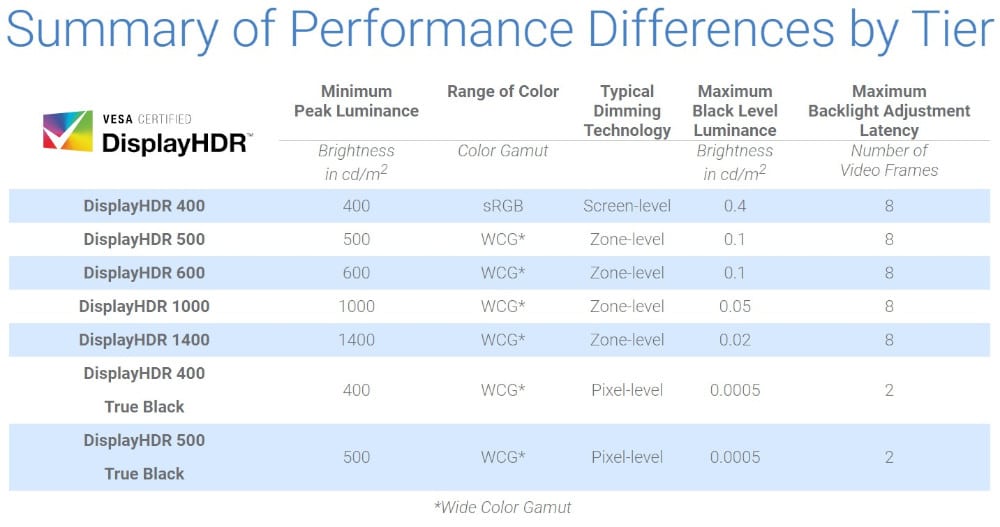

La HDR est un des points les plus traîtres, car il existe une multitude d’appellations HDR mais une seule d’entre elles est réellement une certification sérieuse. On peut citer HDR, HDR10, HDR10+, VESA HDR… Mais dans notre cas un seul est réellement utile : VESA HDR.

VESA est une organisation qui regroupe des constructeurs de matériel informatique dont le but est de définir des standards vidéo et de standardiser certains composants. C’est entre autres à eux que l’on doit la fixation standard pour écran, le DisplayPort dont on a parlé précédemment et ce qui nous intéresse présentement : le standard VESA HDR.

Premièrement petite introduction, c’est quoi le HDR ? HDR est l’abréviation pour High Dynamic Range. La HDR change la saturation des couleurs, les rendant plus vive. Cette technologie augmente également le contraste via des modifications de la luminosité maximale. On parle de changement de plage dynamique. Cette dernière étant simplement l’écart entre la valeur la plus haute et la plus basse pour une grandeur donnée.

Passons maintenant au cœur du sujet : les normes. Ces changements de plage dynamique sont effectués au niveau software, mais rien ne réglemente l’écran en lui-même. On peut donc avoir deux écrans certifiés HDR10 dont la qualité d’image est différente du fait des différence physique entre les écrans PC.

C’est là que VESA intervient, leur certification HDR oblige l’écran à répondre à certains critères pour garantir un plancher minimum de qualité pour chaque label. Chacun des labels HDR spécifie donc un minimum en puissance lumineuse, en profondeur et reproduction des couleurs, etc…

Il existe actuellement sept normes VESA HDR : cinq pour les écrans normaux et deux qui ont été rajoutés spécialement pour les écrans PC OLED (les normes VESA True Black).

Sept normes peuvent paraître beaucoup, mais cette hiérarchie est nécessaire. Un écran HDR1000 fournit un résultat à des années lumières de ce qu’un écran HDR400 peut faire. Les distinguer permet donc au consommateur de savoir où se situe chaque écran et ainsi de plus facilement comparer les tarifs à l’intérieur d’une gamme donnée. Le tableau ci-dessus n’est qu’un aperçu des normes VESA, si vous souhaitez creuser le sujet, le détail est disponible sur leur site.

Avant de passer aux espaces colorimétriques, attardons-nous sur ce tableau, plus précisément la colonne « Typical Diming Technology ». Ici figurent trois type de technologies : « Pixel-Level » qui signifie que la luminosité de chaque pixel peut être adressée individuellement (OLED et Micro LED). Quand aux deux autres type « Screen-level » et « Zone-level » ils concernent les écrans LCD (IPS, VA et TN).

Quand on parle de « Screen-level » cela signifie que le rétro-éclairage de l’écran est formé d’un seul bloc. La grande majorité des écrans PC du marché fonctionnent sur ce principe. Ceux-ci possède un rétro-éclairage sur les bords de la dalle et lorsque sa luminosité baisse elle baisse partout. Pour ce qui est du « Zone-level » on en a déjà parlé lorsqu’on a abordé le Mini LED. À savoir que certains écrans ont un rétro-éclairage derrière toute la dalle (au lieu de juste sur les bords) et qui peut être adressé par zones. Si on a à faire à un écran classique, il y aura quelques centaines de zones et si l’écran est équipé d’un rétro-éclairage Mini LED alors le nombre de zone approche du millier. Dans tous les cas on parlera alors de FALD pour Full Array Local Dimming, comme sur, par exemple, le Acer Predator X27P ou encore le ASUS ROG PG35VQ.

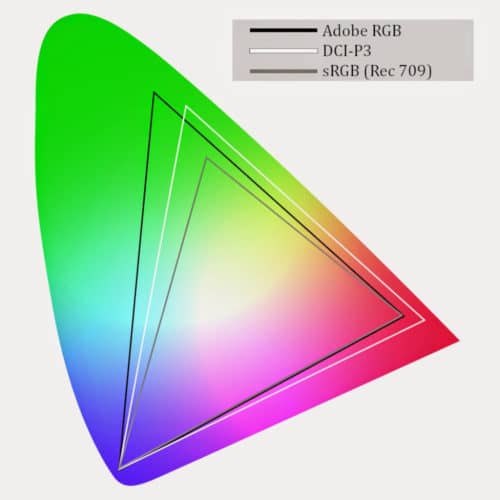

Espace colorimétrique

Vous l’aurez remarqué, les normes VESA HDR utilisent des termes barbares tels que sRGB ou DCI-P3. Derrière ces termes se cache un concept en réalité plutôt simple. En effet il s’agit là de noms donnés à des espaces de couleurs.

Définir un espace colorimétrique permet d’indiquer quelles couleurs l’écran est capable de reproduire, parmi toutes celles que l’œil humain peut voir. Il existe une multitude d’espace colorimétrique mais trois d’entre eux reviennent souvent :

- sRGB

- Adobe RGB

- DCI-P3

Chacun de ces profils est capable de reproduire une gamme plus ou moins large de couleurs.

La grande forme en arrière-plan représente la gamme de couleurs visibles par l’homme, puis chaque triangle indique ce dont chaque espace est capable. L’espace le plus réduit, le sRGB, couvre environ 36% des couleurs visibles. Quant au plus étendu des trois, le DCI-P3, il couvre environ 54% des couleurs visibles.

Devez-vous vous soucier de cette caractéristique lors de votre achat ? Cela dépend. Si vous êtes dans la photographie ou la vidéo alors oui. Prendre un écran avec un grand espace colorimétrique sera essentiel à votre travail. Si vous êtes un utilisateur lambda alors nul besoin de dépenser une grosse somme d’argent pour acheter un écran supportant un espace colorimétrique énorme.

En revanche, même pour un utilisateur classique, il est intéressant de s’informer de la calibration de l’écran. En effet couvrir 100% de l’espace sRGB n’est pas suffisant, il faut encore que la dalle soit correctement calibrée. Malheureusement, à moins que votre écran soit certifié comme étant calibré d’usine, il vous faudra vous-même arpenter les tests afin de connaître le niveau de précision de l’écran qui vous intéresse.

LFR, Flicker Free, Retina et autre jargon technologique

Nous arrivons presque à la fin de ce voyage au cœur des spécifications d’écrans PC. Mais avant de conclure passons tout de même en revue quelques dernières technologies. Commençons par une dont vous avez susurrement entendu parler :

|

Si vous avez une fois entendu parler d’Apple vous avez forcément entendu parler de leurs incroyables écran Retina. La réalité c’est qu’il s’agit d’un terme purement marketing. En effet Retina signifie simplement que l’écran à une densité de pixel suffisamment élevée pour que ces derniers ne soient pas distinguables à l’œil nu. Selon Apple, « suffisamment » signifie environ 300 pixels (ou plus) par pouce (PPI ou Pixel Per Inch en anglais). De ce fait Apple n’est pas la seule marque à vendre des écran Retina. il « suffit » que l’écran ait une haute densité de pixels.

Afin de vous faire une idée voici quelques tailles et résolutions d’écrans avec leur PPI respectifs :

|

|

|

Low Frame Rate compensation ou compensation de faible taux de rafraîchissement. C’est là une technologie présente sur les écrans possédant un rafraîchissement adaptatif (revoir le point sur l’Adaptive Sync). Celle-ci est nécessaire car un écran n’est pas capable de faire varier sont taux de rafraîchissement en-dessous d’un certain seuil.

Illustrons avec un exemple : si la carte graphique descend à 30 FPS alors que l’écran n’est capable de rafraîchissement adaptatif que jusqu’à 48 Hz alors le rafraîchissement adaptatif cessera de fonctionner. C’est pour combattre ce problème que la LFR existe. Son fonctionnement est assez simple, lors qu’il n’y a plus assez d’image par seconde, l’écran duplique certaines images. Certes, cela s’apparente à de la triche, car la même image est juste affichée deux fois de suite. Mais ceci permet de maintenir le rafraîchissement adaptatif en fonctionnement, empêchant ainsi le tearing. |

|

|

Le rétro-éclairage d’un écran peut parfois scintiller, causant une fatigue visuelle chez l’utilisateurs. C’est pourquoi certains écrans s’équipent de la technologie Fliccker-Free. Celle-ci règle le problème de scintillement en contrôlant plus finement le voltage envoyé au rétro-éclairage. Par plus finement on entend plusieurs choses, certains fabricants d’écrans fixent simplement le voltage quand d’autres le font varier à un rythme changeant en fonction de ce que celui-ci affiche. | |

|

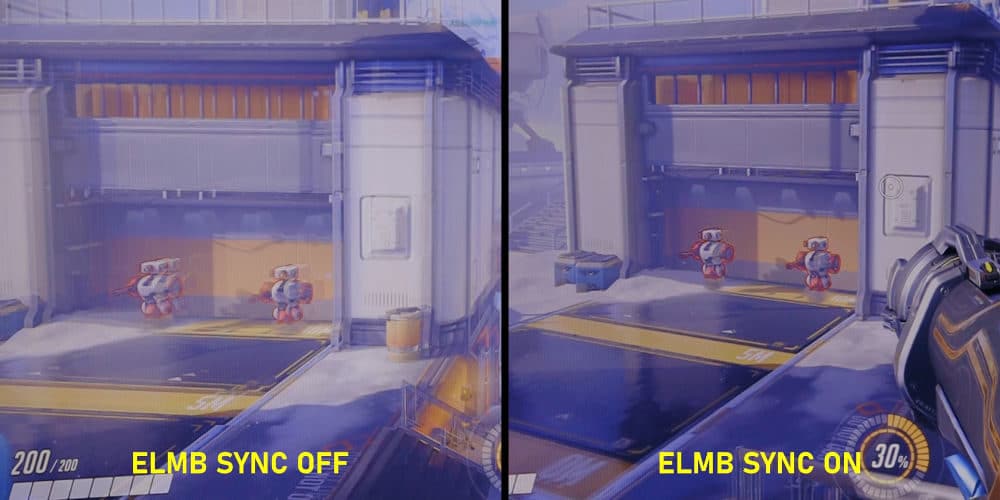

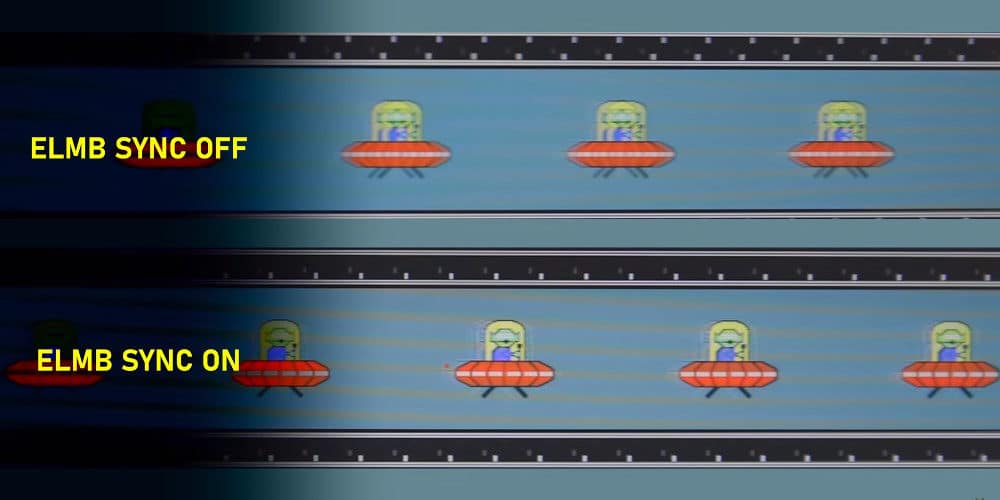

Ou rétro-éclairage stroboscopique en français est une technologie visant à réduire le flou de mouvement. Le flou de mouvement existe à cause de la persistance rétinienne et de la façon dont le cerveau interprète le mouvement. Mais l’homme a trouvé une façon assez simple de combattre la persistance rétinienne à savoir éteindre l’écran entre deux frame. Ceci a pour effet d’empêcher la création du flou de mouvement par l’œil et le cerveau. Vous trouverez cette technologie sous d’autres noms tel que ELMB (Extrem Low Motion Blur), ULMB (Ultra Low Motion Blur), Black Frame Insertion et même ELMB SYNC, une version qui unie la Gsync et l’ELMB. |

Merci beaucoup pour ce guide qui semble hyper complet.

Je ne comprends pas tout ces détails techniques, et ce guide est excellent pour prendre le temps de la réflexion, nécessaire pour ne pas regretter son investissement

Merci beaucoup pour ce retour 😀 !

Très bien réalisé et riche d’infos technique, merci