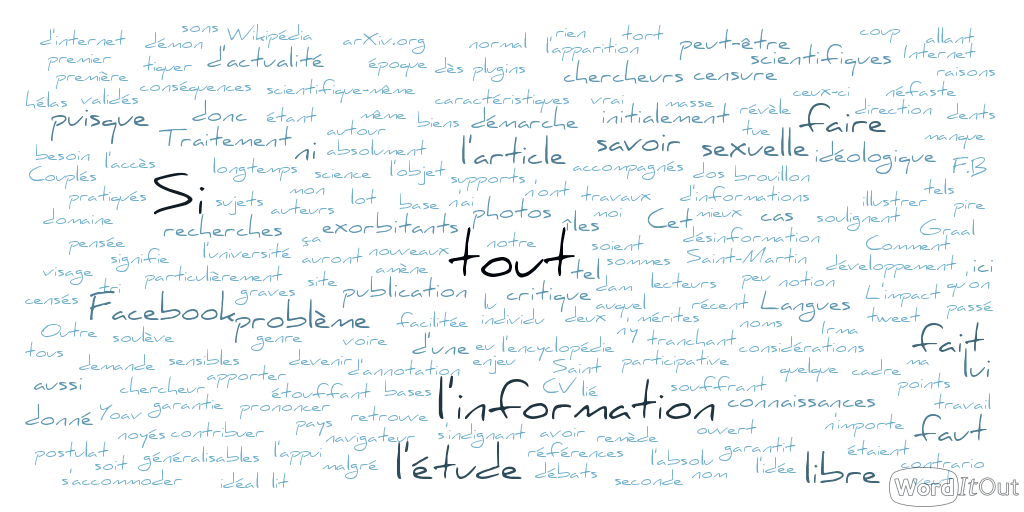

Trop d’informations tue l’information ?

Voilà une affirmation qui pourrait en faire tiquer plus d’un. Comment la libre circulation de l’information, facilitée par les nouvelles technologies et la place toujours plus grande d’internet dans notre quotidien, sans la moindre forme de censure, pourrait-elle être néfaste ?

Un symptôme localisé…

Ce constat auquel je consacre aujourd’hui un article, et qui semble relever du débat idéologique, part initialement d’un coup de gueule d’un chercheur en Traitement Automatique des Langues, Yoav Goldberg. Dans un billet posté sur son blog, où il revient sur les raisons de son désamour pour un article dont il était chargé de la relecture, l’auteur critique le manque de contrôle quant à la diffusion de certaines publications scientifiques, conséquence de l’apparition de nouveaux supports de diffusion tels que arXiv.org, site d’archivage de publications en ligne, permettant la publication et la diffusion de travaux sans que ceux-ci soient relus et donc validés par d’autres chercheurs. Ce qui semble au premier abord très positif, puisque l’accès aux publications est dès lors gratuit et ouvert à tous, se révèle à double tranchant puisque cela amène, selon l’auteur, à l’établissement de nouvelles références – parfois fausses, au grand dam de Goldberg, et en tout cas non certifiées. Ces publications deviennent alors des bases dont les autres chercheurs doivent s’accommoder, au risque (au mieux) de perdre du temps pour refaire l’expérience (dans l’idée scientifique de la reproductibilité) et de voir (au pire) une baisse de la qualité générale des recherches.

Mais une épidémie généralisée

Si ça paraît anecdotique, puisque spécifiquement lié au monde de la recherche et notamment à la recherche en Traitement Automatique des Langues, ce phénomène me semble néanmoins symptomatique d’un enjeu d’ordre sociétal, longtemps vu comme un objectif ultime, un Saint Graal : l’information partout, tout le temps, pour tout le monde, et par tout le monde. Pour ne pas dire par n’importe qui. Je ramènerai ainsi le problème à des considérations plus quotidiennes, à l’image des récents drames liés à l’ouragan Irma dans les îles de Saint-Martin et Saint-Barthélémy qui se sont ainsi accompagnés de campagnes d’information et de désinformation sur Internet. Je me souviens ainsi avoir vu sur mon fil d’actualité Facebook deux publications d’affilée, la première s’indignant des prix exorbitants pratiqués par les compagnies aériennes en direction des îles touchées, photos d’écran à l’appui, la seconde signalant que les publications sur ces prix exorbitants étaient de l’intox.

Je ne m’aventurerais pas à dire qui a raison et qui a tort, je me contenterai simplement ici de souligner qu’il y a eu plusieurs sons de cloche particulièrement contradictoires. Je prends cet exemple pour illustrer le fait que nous sommes submergés par de l’information souvent peu contrôlée. À une époque où la censure est un démon dont il ne faut pas même prononcer le nom, on se retrouve noyés dans une masse de données dont il est parfois difficile de se dépatouiller. Cela peut paraître anecdotique, au vu de l’exemple donné, pourtant les outils pour contrer ce phénomène se multiplient. Decodex, F.B. Purity, et j’en passe, autant de noms de plugins pour navigateur censés faire le tri des informations que vous affiche par exemple votre fil d’actualité Facebook. Couplés aux récentes initiatives de Facebook pour limiter la diffusion de fausses informations, ces outils soulignent la demande, voire le besoin, d’une information contrôlée avant sa diffusion.

Des séquelles non négligeables

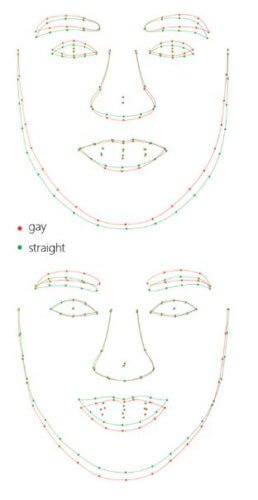

Car les enjeux ne sont pas purement monétaires et ne se limitent pas à savoir si l’on paye effectivement 3 000€ un billet d’avion. L’impact sociétal potentiel est bien plus grand, et j’en prends pour exemple le récent débat autour de l’étude publiée par l’université de Standford concernant la détection automatique de l’orientation sexuelle sur les photos de profil. Outre les risques évidents liés au développement de ce genre d’outils, en allant de la discrimination à l’embauche sur la base de l’orientation sexuelle à partir de votre simple photo de CV à la chasse aux sorcières idéologique et au fichage dans certains pays, et aux questions éthiques qui s’y rapportent, la validité scientifique-même de l’étude est à remettre en question. Si le postulat de l’étude en lui-même, à savoir que l’orientation sexuelle peut être caractérisé par des caractéristiques généralisables et visibles sur un visage, peut faire l’objet de débats, c’est la démarche qui peut surtout être remise en question.

Attention, je ne prétends absolument pas que l’étude, dans son principe comme dans sa réalisation, n’est pas valable. Je n’ai pas les connaissances ni le recul pour me permettre un tel jugement. A contrario, rien ne garantit qu’elle soit valable. Preuve en est le statut de preprint de l’article, qui signifie dans le monde de la recherche scientifique qu’il s’agit là de la version non relue par les pairs et donc pas encore validée. Si la relecture par les pairs n’est pas, dans l’absolu, la garantie ultime de la validité d’une étude, elle permet néanmoins un recul nécessaire sur la qualité d’un travail, recul que les auteurs de l’étude, mais aussi des lecteurs lambda, n’ont pas forcément.

Of course algo can identify images (from dating sites!) as gay or not at better than chance. Of course mturkers are not « human level ».

— (((λ()(λ() ‘yoav)))) (@yoavgo) 11 septembre 2017

Dans le cadre de cette étude, Goldberg (encore lui) soulève ainsi plusieurs points qui peuvent poser problème dans la démarche de l’article, et que vous pouvez retrouver dans les réponses de ce tweet : origine des données (à savoir les images), processus d’annotation de ces données… Si, là encore, Goldberg n’a pas lui non plus la science infuse, ce sont autant de questions qu’il faut se poser lorsque l’on lit un tel article, et que le commun des mortels (je ne suis hélas pas au-dessus du lot) ne se pose pas. Et la question ne se serait pas posée si l’article était passé par un processus de relecture normal avant sa diffusion. Or, les conséquences de l’application de telles recherches, non validées scientifiquement (par les pairs, j’entends), peuvent rapidement devenir graves, surtout sur des sujets aussi sensibles.

Un mal qui fait du bien ?

Il ne s’agit pourtant pas ici de critiquer la notion de partage libre. Il serait en effet malvenu de ma part d’oublier les origines de l’encyclopédie en ligne Wikipédia, par exemple, initialement pensée comme un brouillon pour une encyclopédie quant à elle bien plus contrôlée, et souffrant d’un système de relecture et de contrôle étouffant grand nombre de contributeurs. La possibilité de contribuer librement, et de voir sa contribution corrigée par d’autres contributeurs, encore et encore, a ainsi allégé et facilité le partage de connaissances, donnant ainsi naissance à la plus grande encyclopédie participative à ce jour, et qui a bien des mérites, malgré tout ce qu’on veut lui mettre sur le dos. Il est d’ailleurs intéressant de noter que Wikipédia fait depuis toujours l’objet d’un contrôle, à savoir celui des pairs, par le biais de la relecture et de la correction collaborative. Ce qui n’empêche pas de garder du recul sur l’information donnée, comme le soulignent bien souvent les enseignants concernant Wikipédia. On en revient toujours là.

J’évoquais plus haut des outils promettant une modération du contenu. Je ne saurais vous décrire les mérites ou les défauts de ces outils, ni faire dans le cadre de cet article la liste exhaustive de tout ce qui existe, entre plugins, chaînes YouTube, et j’en passe. Je multiplie pour ma part les lectures lorsqu’un sujet m’intéresse, pour confronter au maximum les avis, et garde sinon un regard très extérieur sur les autres sujets que je pourrais survoler, sans m’engager à avoir un avis très affirmé, et encore moins à le partager. Mais tous les moyens sont bons pour se questionner sur l’information que l’on consomme.

Quel remède ?

Cet article ne prétend pas apporter une solution à ce que je considère comme étant le problème de la trop libre circulation des informations, mais qui ne l’est peut-être pas aux yeux de tout le monde. Il n’y a selon moi pas de bonne ou de mauvaise réponse. À vrai dire, la libre circulation des informations n’est ni un mal, ni un bien. Tout dépend de ce que l’on en fait.

Ce qui peut paraître très spécifique à un domaine de recherche donné (le processus de relecture et de publication d’articles scientifiques) est en fait symptomatique et à l’origine d’un phénomène sociétal. Il faut que tout aille plus vite, plus loin (à plus grande échelle) pour que tout le monde puisse se l’approprier, y compris l’information. Dans un monde idéal, chaque individu aurait le sens critique nécessaire pour faire la part des choses et consommer comme il se doit ces biens indispensables que sont l’information et la connaissance. Quand les poules auront des dents, peut-être. Si ce n’est pas déjà le cas, à ce que j’ai lu quelque part…